¿Nunca has tenido la sensación de que Google te muestra lo que quieres ver en vez de lo que has buscado? ¿Cuántas veces has buscado algo o hablado de algo y ves que hasta los anuncios parece que te han oído? ¿Te has fijado lo que pasa cuando ves en un red social, por ejemplo vídeos de "gatitos", cómo de repente te empiezan a recomendar tantos vídeos de gatitos que no podrías terminar de verlos ni en una vida... Incluso cuando quieres prestar tu atención en otra cosa, tu atención es robada por vídeos de gatitos... Sí, los algoritmos de búsqueda y de recomendación tienen vida propia y compiten por tu atención.

¿Te has planteado alguna vez cuando buscas en Google, si realmente te está buscando el mejor resultado de acuerdo a tu búsqueda? ¿O es una búsqueda sesgada por intereses comerciales (mayormente publicitarios), mezclada con contenido que capte tu atención y te retenga? Si usas el buscador de Google, te adelanto que estás en el segundo caso y lo que debería ser una búsqueda de acuerdo a posicionamiento natural u orgánico, resulta que no lo es, siendo algo coyuntural y anecdótico lo que realmente buscas. Esto quiere decir que los resultados mostrados no son los que tú estás buscando, sino los que Google por diversos ajustes en sus algoritmos está seleccionado para ti.

Esto crea lo que se conoce como un efecto burbuja de información y de contenido, los algoritmos de búsqueda y recomendación van a reforzar el tipo de búsquedas que mejor encajen con tu perfil, porque sí, lo que Google busca es hacer perfiles, conocerte mejor, para ofrecer el mejor servicio de publicidad del mundo y eso implica entender qué llama tu atención. Alguno puede pensar que se salva porque navega de manera privada en Chrome, y nada más lejos de la realidad. Chrome es la punta de lanza con la que Google ha copado el mercado de los navegadores y que usa para que su negocio de publicidad esté mejor controlado y sea más prospero.

Tampoco te libras si usas Firefox y usas el buscador de Google. Ni aún navegando en privado, ya que siempre hay elementos que pueden identificarte (aunque Firefox trabaja incansablemente para protegerte de ese rastreo), como la IP desde la que te conectas que puede acotar una zona geográfica, las maravillosas cookies (esas que acabas aceptando porque no puedes decir que no), las cosas que buscas (dónde entras..., qué miras...) ...

⚠️ Recuerda que todo esto no es por la privacidad, que también debería importarte, sino que esto va de la visión sesgada que recibes cuando un buscador como el de Google da los resultados que da cuando haces una búsqueda, los cuales son sesgados y acomodados a tu perfil.

Todo esto se mezcla con el SEO (Search Engine Optimization) y el SEM (Search Engine Marketing), que en sí constituyen un negocio, en el que al final el que más relevancia tiene suele ser el que más paga… Alguno pensará que es normal, y lo era... Ya que antiguamente Google tenía en el resultado que veías sin hacer scroll, una parte de resultados orgánicos y otra de promocionados. Actualmente voces del sector dicen que toda la primera página, y hasta la décima página de resultados, son resultado convenientemente colocados por Google, ya sea para publicitarte algo o para retener tu atención de una forma u otra. Sobre este tema, puedes encontrar un buen documental en Neflix llamado "El dilema de las redes sociales" .

Qwant una alternativa a Google con sello Europeo 🇪🇺

Qwant es un buscador que se autodefine como "el primer motor de búsqueda europeo, eficiente y ético". Su motor de búsqueda respeta tu privacidad, y esto lo hace ofreciendo una garantía de neutralidad e imparcialidad en la que ofrece los mejores resultados disponibles para tus consultas y nunca intenta adivinar quién eres o qué estás haciendo. Esto hace que toda la web sea visible "sin ninguna discriminación y sin prejuicios". Afirman que sus algoritmos de clasificación "se aplican por igual en todas partes y para todos los usuarios, sin intentar presentar sitios web o esconder otros basados en intereses comerciales, políticos o morales".

Instalación en Firefox 💾

La instalación en Firefox es muy cómoda. Entra en Qwant dale a "Add Qwan to Firefox" y sigue los pasos.

Puedes elegir que Qwant sea tu motor de búsqueda por defecto o no, pudiendo cambiar los ajustes en "Opciones > Buscar". 💡 Como consejo adicional decirte que puedes asignar atajos para indicar si usas un buscador u otro en tus búsquedas en la barra del navegador (por ejemplo "q mascandobits" o "@google mascandobits").

💡 También puedes seleccionar el motor de búsqueda desde la barra de búsqueda antes de darle a enter, seleccionado el buscador que quieres usar.

Más ℹ️ información en la ayuda de Firefox.

Móvil 📱

Para Firefox móvil la cosa no es tan cómoda, pero puedes añadir Qwant como motor de búsqueda y si quieres puedes hacerlo buscador predeterminado en "Ajustes > Buscar". Si quieres añadir Qwant como motor de búsqueda, dale a "Añadir buscador > Otro" y rellenas:

- Nombre: Qwant

- Cadena de búsqueda a usar: https://www.qwant.com/?l=es&q=%s

Con eso ya puedes usar Qwant desde tu Firefox móvil. Lamentablemente tiene que hacerse así porque la extensión de Qwant no funciona en la versión móvil, como tantas otras que requieren de una actualización para ser usadas en versiones modernas de Firefox.

Instalación en Chrome 💾

La instalación en Chrome también es muy cómoda, aunque nos metemos en la guarida del lobo (a Google no le gusta que el motor de búsqueda en Chrome sea otro al suyo) y tienes sus peros. Entra en Qwant dale a "Add Qwan to Chrome" y sigue los pasos.

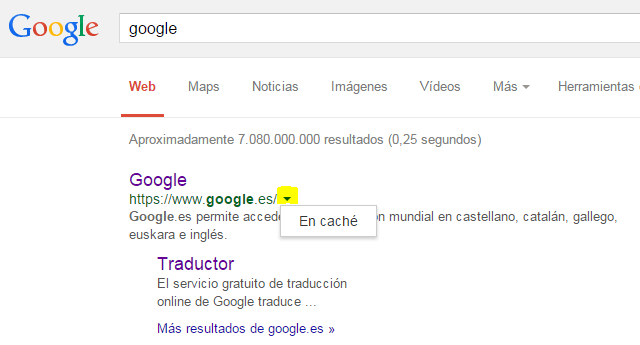

Por motivos internos que se desconocen y que no han trascendido, con la extensión de Qwant obligatoriamente tienes que usarlo como motor predeterminado y desactivar la extensión para elegir otro. Seguramente tenga mucho que ver con estos mensajes que te saltan en el navegador, en un amago de rescatar la posición de privilegio del motor de Google en su navegador Chrome:

Entiendo que no es una opción del todo cómoda, pero si quieres tener la posibilidad de elegir motor de búsqueda predeterminado puedes introducirlo manualmente. Google se reserva el hecho de sacarlo en cualquier momento de la lista de motores de búsqueda predeterminados, razón por la que ya ha sido varias veces sancionado por la Unión Europea por abuso de posición dominante. Para ello ve a "Configuración > Buscador > Administrador buscadores". Si quieres añadir Qwant como motor de búsqueda dale a "Añadir" en las sección "Otros buscadores" y rellenas:

Un vez creado aparecerá en la lista que hay debajo de "Otros buscadores", dale a los tres puntos para establecerlo como predeterminado.

⚠️ Si lo quitas como predeterminado desaparecerá de la lista de los navegadores seleccionables y tendrás que volver a hacer este paso de añadirlo como predeterminado.

Ahora veis la razón del comportamiento de la extensión de Qwant. 😎 En cualquier caso, aunque lo quitéis como predeterminado lo podréis seguir usando para buscar si usáis la palabra clave al principio de vuestra búsqueda en la barra de búsqueda de Chrome (por ejemplo "@qwant mascandobits").

Móvil 📱

Para Chrome móvil, siendo Android bastión de Chrome, la cosa está complicada y mucho... Es imposible añadir un nuevo buscador en "Configuración > Buscador", sólo permite elegir entre los que te ofrece y vuelve a reservarse el derecho Google de poner su buscador como buscador predeterminado.

Aún así existe una pequeña opción de usar Qwant como motor de búsqueda predeterminado. Es iniciando sesión con una cuenta de Google en Chrome, en un equipo de sobremesa y habilitar la sincronización, pudiendo así sincronizar extensiones. ¡Muy buena Google!, así puedes controlar la extensión, no se te escapa una 😉😅. Reza el dicho que: "mantengas cerca a tus amigos, pero aún más cerca a tus enemigos".

Tristemente la mejor opción de usar Qwant en Chrome desde un móvil, es estableciendo Qwant como página principal. 😢

Impresiones

Llevo ya unos cuantos meses usándolo y estoy encantado con Qwant, lo tengo como motor principal de búsqueda. No lo he sustituido completamente por Google, porque a veces resulta interesante el efecto burbuja de los resultados de sus búsquedas, sobre todo en ámbitos profesionales. No obstante cuando quiero abrir mi mundo, mi herramienta es Qwant sin duda.

Además no debemos olvidar que cotejar varias fuentes es algo básico en nuestra sociedad de la "desinformación". Y un buscador por mucho que nuestras leyes digan que es, o debería ser, un agente neutro, no lo es. Coteja varios resultados de distintos buscadores siempre y no uses sólo uno.